Das Glückslager – ein simples Rad, doch dahinter verbirgt sich ein tiefes Prinzip: Zufall ist nicht Chaos, sondern Struktur. Wie die Quantenmechanik zeigt, wo Heisenberg die Grenzen der Beobachtung aufzeigt, so offenbart auch das unvorhersehbare Drehen eines Lucky Wheels, dass Zufall mathematisch fundiert ist. Dieses Rad wird zur lebendigen Metapher für Wahrscheinlichkeitsverteilungen, Entropie und die Information, die aus unsicheren Ereignissen entsteht.

1. Das Prinzip des Zufalls: Die Unschärfe der Wahrheit

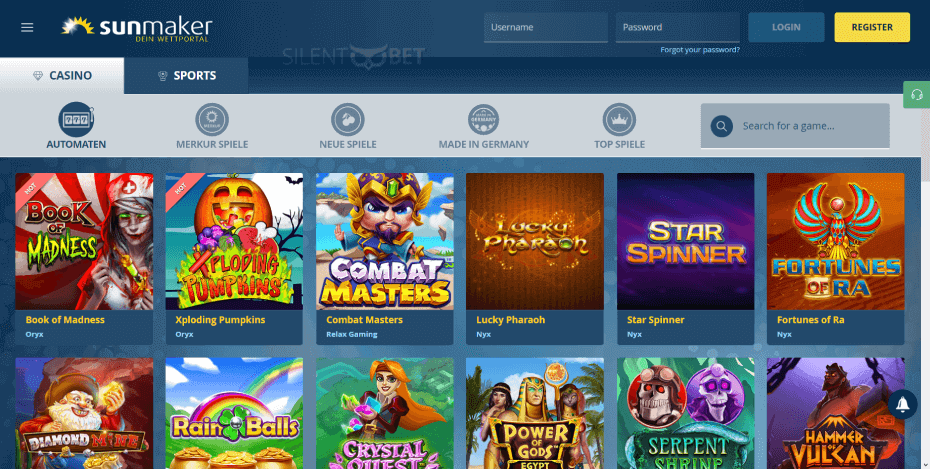

Heisenbergs Unschärferelation lehrt uns, dass bestimmte Paare physikalischer Größen wie Ort und Impuls niemals gleichzeitig determiniert sein können – eine fundamentale Unsicherheit, die der Zufall strukturell prägt. In der Quantenwelt ist der Ausgang eines Ereignisses nicht vorherbestimmt, sondern wird durch Wahrscheinlichkeit bestimmt. Diese Idee überträgt sich elegant auf das Lucky Wheel: Jede Drehung liefert kein festes Ergebnis, sondern eine gleichverteilte Möglichkeit – ein Zufall, der nicht willkürlich, sondern statistisch vorhersehbar ist.

Heisenberg und die Grenzen der Beobachtung

Heisenberg zeigte, dass das Beobachten eines Quantensystems dieses notwendigerweise stört. Dies bedeutet: Je genauer wir eine Größe messen, desto ungenauer wird eine andere. Ähnlich verhält es sich beim Glücksrad: Wir können den Drehpunkt nicht exakt kennen, nur die gleichmäßige Wahrscheinlichkeit der Positionen. Jeder Punkt auf dem Rad hat die gleiche Chance – doch das Ergebnis bleibt offen, bis die Drehung endet.

- Heisenberg: Die Natur lässt sich nicht deterministisch vorhersagen

- Quantenereignisse folgen Wahrscheinlichkeitsregeln, nicht festen Mustern

- Das Lucky Wheel zeigt dieselbe Gleichverteilung: keine Vorhersage, nur Chancen

„Zufall ist nicht das Fehlen von Ordnung, sondern ihre natürliche Form.“

2. Zufall als Information: Kullback-Leibler-Divergenz und deren Rolle

Die Kullback-Leibler-Divergenz (DKL) misst, wie sehr sich zwei Wahrscheinlichkeitsverteilungen unterscheiden – ein Maß für Informationsverlust oder Überraschung. Wenn wir ein Rad drehen, erhalten wir kein vorbestimmtes Ergebnis, sondern eine Überraschung. DKL(P||Q) ist niemals negativ und quantifiziert, wie unerwartet der Ausgang ist im Vergleich zu einer erwarteten Verteilung. Diese Regel beschreibt, wie Zufall und Erwartung in Einklang bleiben: Das Rad bleibt fair, doch das Ergebnis bleibt offen – bis wir entscheiden, was daraus wird.

DKL(P||Q) = Σ P(x) · log(P(x)/Q(x)) Diese Formel zeigt: Je größer der Unterschied zwischen beobachteter und erwarteter Verteilung, desto mehr „Information“ wird gewonnen. Beim Lucky Wheel bedeutet jeder Dreh ein neues Ereignis, das unsere Unsicherheit verringert – das Rad lenkt uns durch Zufall, aber die Wahrscheinlichkeit bleibt konstant. DKL hilft, diesen Informationsgewinn zu quantifizieren: Ein Rad mit gleichverteilten Feldern maximiert Entropie und damit Informationspotenzial.

Die Drehung des Rades ist eine eindrucksvolle Metapher für mehrdimensionale Wahrscheinlichkeitsverteilungen. Jede Zone entspricht einem Zustand, und jede gleich große Fläche symbolisiert eine Wahrscheinlichkeit von 1/n. Doch obwohl jeder Punkt gleich wahrscheinlich ist, bleibt das Ergebnis offen – bis die Drehung abgeschlossen ist. Ähnlich verhält es sich in der Informationstheorie: Der Zustand des Rades enthält maximale Entropie, doch der Ausgang bleibt ein Überraschungsereignis. Das Rad ist kein Zufall im Chaos, sondern eine geordnete Unordnung.

Sphärische Harmonische und Drehimpuls beschreiben die mathematische Struktur, die jedem Feld eine Wahrscheinlichkeit zuordnet. Das Lucky Wheel veranschaulicht, wie multidimensionale Verteilungen – etwa mit mehreren Spulen oder Bereichen – entstehen. Jede Drehung ist ein Ereignis aus einem n-dimensionalen Raum, bei dem nur der Ausgang, nicht die Verteilung vorhersagbar ist. Dieses Prinzip spiegelt die Informationstheorie wider: Der Zustandsraum ist breit, doch die Wahrscheinlichkeiten sind gleich – bis die Entscheidung fällt.

„Das Rad zeigt: Gleichverteilung ist die Form des vollständigen Zufalls.“ Entropie misst die Unordnung oder Unsicherheit in einem System. In der Thermodynamik steigt Entropie stets – doch im Lucky Wheel wird sie sichtbar durch die Drehung selbst: Jeder Wurf erhöht die Unsicherheit, bis der Moment des Erfolgs kommt. Die Entropie wächst mit der Anzahl gleichverteilter Zustände, die das Rad bietet. Gerade diese Unbestimmtheit macht den Zufall leistungsfähig: Je größer die Entropie, desto mehr Informationspotenzial steckt im Ergebnis.

Entropie E ist definiert als E = -Σ P(x) · log₂ P(x), gemessen in Bit. Beim Lucky Wheel ist P(x) = 1/n – gleichverteilt. Die Entropie erreicht ihr Maximum, wenn alle Zustände gleich wahrscheinlich sind. Dieses Maximum repräsentiert die höchste Unsicherheit und damit das größte Informationspotenzial. Jeder Dreh erhöht die Entropie, bis der Ausgang feststeht –信息获取通过随机性驱动。

„Hohe Entropie bedeutet maximale Unsicherheit – und damit größte Informationsfreiheit.“ Die Drehung des Rades erzwingt eine Entscheidung: Wer wählt das Feld, das zum Glück fällt? Die Wahrscheinlichkeitsverteilung bestimmt Chancen, aber der Ausgang bleibt offen – bis wir uns entscheiden. Dies spiegelt reale Entscheidungsprozesse wider: Risiko, Nutzen und Wahrscheinlichkeit treffen aufeinander. Das Rad ist nicht nur ein Spiel, sondern ein Modell dafür, wie Information aus Unsicherheit entsteht und zu Handlung führt.

„Jede Drehung ist ein Aufruf zur Wahl – und jede Wahl trägt Information.“ Die Entscheidung nach dem Radwurf ist der Moment, in dem Zufall zu Information wird. Die Wahrscheinlichkeit bestimmt die Chancen, doch der Ausgang bleibt offen – bis wir uns entscheiden. Diese Schnittstelle zwischen Unbestimmtheit und Handlung ist zentral: Das Rad liefert Daten, die Entscheidung fügt Sinn hinzu. In der Informationstheorie entspricht dies der Übertragung: Nur wenn Unsicherheit in klare Botschaften übersetzt wird, entsteht Information. Das Lucky Wheel zeigt, wie Zufall durch Wahl zu Wissen wird.

„Aus Zufall wird Information durch die Entscheidung, die folgt.“Zufall als Information: Kullback-Leibler-Divergenz und deren Rolle

3. Wahrscheinlichkeitsverteilungen und der Lucky Wheel als Metapher

Wahrscheinlichkeitsverteilungen und der Lucky Wheel als Metapher

Zustände

Wahrscheinlichkeit

jeder Punkt

1/n

alle möglichen Drehpositionen

gleichverteilt

4. Entropie im System: Unsicherheit als treibende Kraft

Entropie im System: Unsicherheit als treibende Kraft

5. Information durch Entscheidung: Vom Zufallswurf zur Wahl

Information durch Entscheidung: Vom Zufallswurf zur Wahl